-

Compteur de contenus

1 088 -

Inscription

-

Dernière visite

Tout ce qui a été posté par jmaffert

-

Bonsoir Dominique, sujets toujours intéressants, mais ce n'est pas un trichaptum ! Ce sont des espèces minces et pas ce gros polypore que l'on voit dans ta première photo. La photo de la "face inférieure d'un sujet jeune" est la photo de pores de Trametes gibbosa. La première photo peut faire penser à un vieux polypore soufré, mais il faudrait au moins une vue de dessous. Bien cordialement Jérôme Maffert

-

Trouver de l'éclairage pour les orthoplans !

jmaffert a répondu à un(e) sujet de denisgast dans Leitz LEICA

Tout à fait, mais assez cher avec le transport et les droits de douane... -

Trouver de l'éclairage pour les orthoplans !

jmaffert a répondu à un(e) sujet de denisgast dans Leitz LEICA

Bonjour, non ça ne ressemble pas à un éclairage d'Orthoplan, d'ailleurs il est écrit Ortholux II. Ca ne se montera pas. Cordialement -

Trouver de l'éclairage pour les orthoplans !

jmaffert a répondu à un(e) sujet de denisgast dans Leitz LEICA

C'est quand même pratique d'avoir un boîtier Orthoplan pour l'interface mécanique et le condenseur. On peut mettre une diode laser dedans : voir mon article dans Mik-Mag. Il n'y en a malheureusement pas en vente sur eBay en ce moment. Cordialement -

Logiciel photo et camera

jmaffert a répondu à un(e) sujet de Erhelge dans QUESTIONS POSEES PAR LES VISITEURS A MIKOSCOPIA

Je suis comme Jean-Luc, je travaille sur Mac. J'ai une caméra Moticam 3Mp avec un logiciel complet qui tourne bien sur Mac. Elle est en USB2 et ne fonctionne pas sur un port USB3. Pour m'en servir, j'utilise un vieux Macbook Pro qui a un port USB2. Plus tard, j'ai acheté une caméra Digiretina 16 en USB3, qui ne fonctionne pas sur un port USB2, dont le logiciel Mac assure un service minimum et ne permet en particulier pas les mesures, qui sont indispensables pour moi. Pour mesurer j'utilise Image J, qui est un logiciel puissant de traitement d'images (pas pour améliorer les images, mais pour des traitements scientifiques), gratuit, qui tourne sur Mac et qui a de bonnes fonctions de mesure. Il faut étalonner une fois (pour chaque objectif) en regardant un micromètre. Ensuite on fait facilement des mesures. En résumé, il y a donc des marques qui vendent des caméras pour microscope qui fonctionnent avec un Mac, mais il faut s'en assurer avant d'acheter. Attention au problème USB2 - USB3. Si des fonctions manquent, Image J rend de grands services (j'ai la doc, mais elle fait 10 Mo; je peux l'envoyer via un courriel si quelqu'un est intéressé). Cordialement -

Certes ils encourent des sanctions terribles, mais que sera-t-il appliqué en réalité ?

-

Bonsoir, je n'aime pas beaucoup l'expression "la limite de Abbe peut être facilement dépassée en utilisant la fluorescence". Cela pourrait laisser entendre que cette limite physique (calculée et mesurée) pourrait être dépassée, ce qui est bien sûr faux. Quand on veut parler sciences ou technique, il faut peser ses mots. Dans une autre configuration, avec un autre montage expérimental (celui de la microscopie confocale) on obtient une résolution angulaire un peu meilleure qu'un microscope classique, ainsi qu'une image en trois dimensions. On ne doit donc pas dire que la limite de Abbe peut être dépassée, mais qu'avec un montage expérimental tout à fait différent, on a une autre limite de résolution, ce qui est tout à fait exact; Par ailleurs la microscopie confocale ne marche pas qu'en fluorescence, mais aussi avec un éclairage de l'objet. Cordialement

-

Bonjour, je suppose qu'il y a une lentille de Bertrand escamotable comme sur le même module pour Orthoplan. J'utilise le même genre de module sur Orthoplan depuis des années. C'est très agréable. Effectivement on ne se rend pas compte que le module est en place, car la qualité optique est excellente. Quand on a de bons objectifs, le grossissement 10x des oculaires est un peu faible pour saisir les petits détails. Sur Orthoplan ça monte au grossissement 3,2x, peu utilisable car la luminosité s'effondre. Je vais rarement au delà de 2x. Seul souci que j'ai eu : des erreurs de mesure en oubliant que le zoom n'était pas sur 1x ! Cordialement

-

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Désolé des messages se sont croisés. L'article de Gatimel est un amas de conneries, qu'il n'a pas inventées, mais simplement recopiées sans comprendre. Espérons qu'il est meilleur praticien que physicien (c'est ce qu'on lui demande). Le premier schéma correspond au deuxième que j'ai dessiné il y a deux jours dans ce même sujet. Il n'a bien sur pas vu qu'en décalant légèrement l'image sur la rétine, le signal disparaissait... Son deuxième schéma est totalement faux car il n'a pas réalisé que les capteurs avaient une surface et n'échantillonnaient pas "ponctuellement". Dans une bande de luminance uniforme, il n'y a pas d'aliasing, etc... C'est l'exemple typique de connaissances mal digérées et d'un manque de réflexion personnelle. On ne peut pas lui en vouloir car les études de médecine ne sont pas des études de physique. A titre d'anecdote, j'ai été deux ans assistant de physique en faculté de médecine. Le Professeur de physique était un médecin. (Aïe ! Aïe Aïe ! ) Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Astigmatisme Citation : "L'astigmatisme n'est pas amélioré par un grossissement supérieur. Avec un 20 X tu auras le même astigmatisme qu'avec un 10 X . C'est ton œil qui est astigmate et il le restera, Ou alors tu as aussi une correction dioptrique en plus de l'astigmatisme. Mais qui n'est pas astigmate ? L'astigmatisme n'est pas toujours gênant et ne nécessite pas toujours une correction tout dépend de son degré et de la gêne." L'astigmatisme, comme d'autres aberrations, diminue l'acuité visuelle. On voit les grosses lettres chez un ophtalmologue, pas les petites. Un oculaire plus puissant agrandit l'image. Les aberrations de l'oeil sont alors moins sensibles. Une paire d'oculaires coûte beaucoup moins cher qu'un zoom de microscope... Cordialement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Désolé, tant que tu appliqueras à tort/hors contexte un très intéressant et exact théorème de traitement du signal, je réagirai. Comme exemple d'article citant à tort ce théorème je t'envoie sur : http://www.gatinel.com/glossaire/nyquist-theoreme-de/ qui est un amas d'idioties d'un médecin spécialiste qui n'a rien compris et qui se gargarise de théories auxquelles il n'a rien compris. Il y a aussi plein d'articles de photographie dans le même style. Tout le monde se recopiant, sans comprendre, ce qui ne m'étonne pas car c'est compliqué (il suffit de lire l'article dans Wikipédia sur ce théorème, par exemple). Si dans "tous les documents que j'ai pu consulter" tu en as de sérieux, je suis preneur. S'il y a des exemples concrets, je suis aussi preneur. Je reconnais que 10 est un arrondi. Quand je disais 2 à 3 c'était 2 à 3 fois plus que Shannon. En fait ça devient convenable vers 8 à 10 échantillons par cycle. Pour t'en rendre compte, échantillonne une sinusoïde avec des durées variables, comme je l'ai représenté dans mes dessins précédents. Tu verra de toi-même à partir de combien d'échantillons ça commence à ressemble au signal qu'il aurait fallu restituer. Si tu trouves qu'à 2,3 échantillon par cycle le signal ressemble à quelque chose, c'est désespéré. Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

"Plus les photosites sont petits actuellement environ 1,4 µm pour 14 Mp.Plus l'image restituée est grande et donc plus facilement recadrable.Illusion, il n'y a pas plus de détails." Il vaut mieux lire : - plus il y a de pixels, plus l'image est recadrable - plus les pixels sont petits, mieux l'image intermédiaire est restituée " Plus les détails sont fins. Illusion, les détails sont sur l'image intermédiaire pas créés par la camera." Heureusement que la caméra ne crée pas de détails ! pour qu'elle ne les fasse pas disparaître, il faut échantillonner avec beaucoup de petits photosites... Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Tout à fait d'accord. A la question sur les oculaires : - plus le grossissement est faible, plus le champ est grand et inversement - il est plus rapide de changer un oculaire qu'un objectif. Nos anciens avaient des microscopes à 1 ou 3 objectifs, pas à 5 ou 6 et pas de tourelles interchangeables. - les oculaires sont moins chers que les objectifs Ceci dit avec un très bon objectif, je trouve que le grossissement de 10 est un peu insuffisant (mes yeux ont de l'astigmatisme...). je me sers donc quelquefois du zoom de mon microscope pour plus de confort sur les petits détails. Je l'oublie d'ailleurs quelquefois et suis surpris par les dimensions que je mesure ! :) Cordialement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

"Bien entendu, si on veut minimiser les effets du crénelage, on peut essayer de diminuer la taille du photo-site, même le plus sot peut le comprendre". C'est exactement ce que je veux dire : l'image au foyer de l'objectif a une certaine qualité, limitée par les lois de la physique et la qualité du microscope. Si on veut la reprendre à l'oeil, on rajoute un oculaire suffisamment puissant pour ne pas atteindre la limite de résolution de l'oeil. Si on veut la reprendre avec un CCD, en la dégradant peu, il faut environ DIX échantillons (photosites) par cycle de la fréquence spatiale maximum que délivre l'objectif. Je ne veux pas faire de la transformée de Fourier, mais observer au mieux l'image fournie par l'objectif. Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Je vois que notre cher Tryphon continue à joyeusement mélanger les concepts : - d'analyse de spectre - de visualisation d'un signal ou d'une image Oui, quand on veut numériser un signal pour en mesurer le spectre, une échantillonnage légèrement supérieur à deux fois la fréquence maximum est suffisant pour retenir l'information fréquentielle. Non, quand on veut visualiser un signal, cet échantillonnage est notoirement insuffisant. Tu t'es probablement servi d'un oscilloscope numérique. T'es-tu demandé à quelle fréquence était échantillonnée la jolie sinusoïde que tu regardes ? certainement à deux échantillons par cycle !! Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

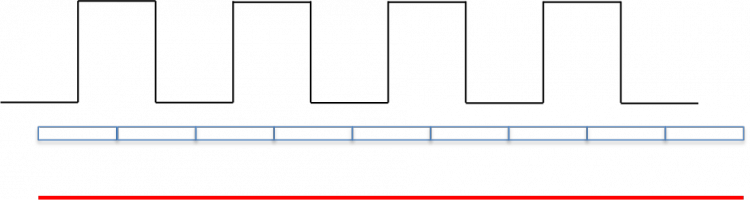

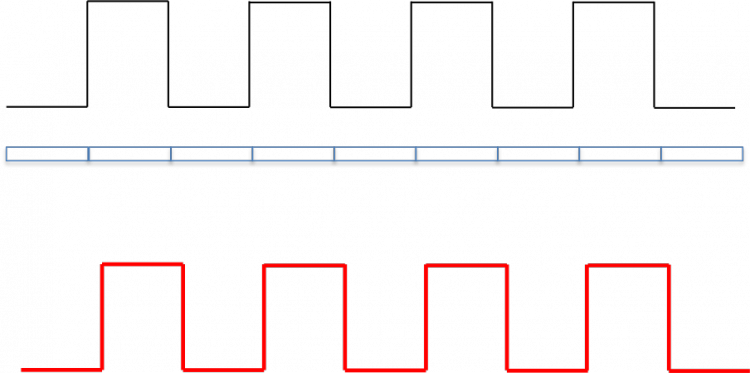

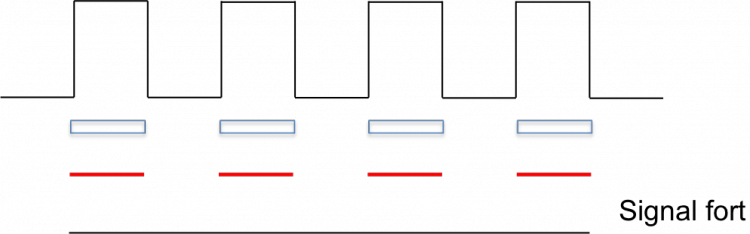

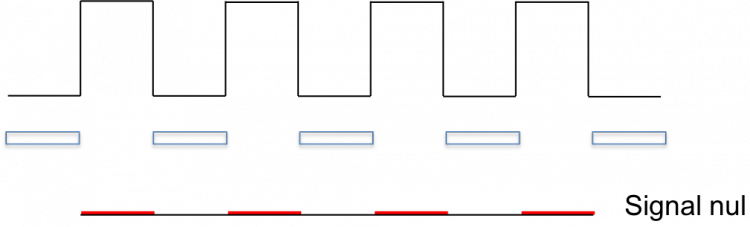

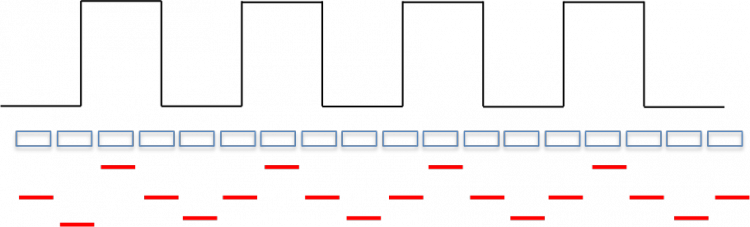

Effectivement, sur ta photo agrandie on voit bien les détails. Le moiré est dû à un échantillonnage très proche de la fréquence que l'on observe. Dans ce cas, selon la synchronisation entre le signal et l'échantillonnage, il y a de grandes variations dans le signal. Un exemple classique est donné par les voilages devant les fenêtres. Quand le tissu est en double dans les plis, selon que les fils sont en face des fils ou en face des trous, on voit des zones plus claires et plus sombres. Comme l'écartement entre les fils n'est pas parfaitement constant, cela fait des dessins. C'est le moirage. Reprenons le cas de l'échantillonnage d'un signal blanc/noir par un CCD. Premier cas à deux photosites par cycle (un cycle c'est un blanc + un noir) : En noir, l'éclairement vu de profil, en bleu les photosites et en rouge le signal de sortie. Ici pas de chance,les photosites captent tous du blanc et du noir en quantité égale : le signal résultant est uniformément gris. En décalant latéralement : Le signal est "parfaitement" restitué. Entre les deux, on percevra plus ou moins de modulation. Si la fréquence d'échantillonnage est légèrement différente de la fréquence qu'on observe, il y aura des endroits où on sera "en phase" où on verra la modulation et des endroits où l'on sera "en quadrature" (décalage d'un quart de cycle) où l'on ne la verra plus, d'où effet de moiré. En sous-échantillonnant comme tu le fait, on se trouve dans le cas suivant où un détecteur sur deux n'est pas utilisé : ou, selon le décalage : Si la fréquence d'échantillonnage n'est pas exactement un sous-multiple de ce qu'on observe, il y aura à nouveau des décalages et des zones plus ou moins claires, d'où à nouveau effet de moirage. A l'inverse, si l'on échantillonne mieux, comme dans l'exemple suivant, à 4 échantillons par cycle : il y a une dégradation du signal, mais il n'y aura pas d'effet de moiré, s'il y a un décalage latéral. En résumé, le moiré apparait en cas d'échantillonnage voisin de deux échantillons par cycle ou un sous-multiple. Un échantillonnage correct du signal nécessite 8 à 10 échantillons par cycle (j'insiste :blink: ), pour ne pas le dégrader et il n'y aura pas de moiré ! Cordialement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Bonjour Jean-Luc, c'est bien de faire des essais réels avec des objectifs différents. Je pense cependant qu'il faudrait ré-agrandir les photos (ou un fragment) pour qu'elles soient à la même échelle, ce qui faciliterait la comparaison. En numérotant tes photos de 1 à 8 : - je ne vois plus les trous sur la photo 2 - sur la photo 3 il y a un effet de moiré, ce qui arrive quand on échantillonne à une fréquence proche de celle de l'objet - photo 7 : est-ce aussi du moiré ? Cordialement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

"Pour l'image c'est pareil, si l'image est meilleure sur les courbes, mais si on ne voit aucune différence à l'écran où au microscope, cela me fait deux belles jambes." Justement, il me semblait qu'on pouvait voir une différence sur les images que j'ai envoyées. Je regrette de ne pas avoir de commentaires directs dessus. "192 000 Hz alors qu'on plafonne à 10 000 et légèrement plus quand on est jeune, çà me fait rigoler." Ne pas confondre fréquence acoustique (ou fréquence spatiale) et fréquence d'échantillonnage. C'est le sujet. Tryphon est un Saint Thomas au carré : (Saint Thomas)2. A Saint Thomas, Notre Seigneur a dit : “Parce que tu m’as vu, tu as cru. Heureux ceux qui n’ont pas vu, et qui ont cru !” » (Jn 20, 24-29). Tryphon voit (des images virtuelles, l'effet de l'échantillonnage) et ne croit toujours pas... Bien amicalement et Joyeux Noël -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

J'essaie simplement d'expliquer que l'échantillonnage au sens de Nyquist-Shannon conserve l'information spectrale mais dégrade le signal. Que pour ne pas trop dégrader le signal, il faut échantillonner à des fréquences plus élevées. Le traitement du signal a de fortes ressemblances entre des signaux électriques, issus de sources différentes : audio, radio, hypefréquences (signaux monodimensionnels, fonction du temps) et de l'optique (signaux bidimensionnels dans l'espace). Beaucoup de règles qui s'appliquent aux uns s'appliquent aux autres. Si des professionnels numérisent les signaux à 192 kHz / 24 bits, c'est pour ne pas les dégrader, les conserver et pouvoir faire du traitement dessus. Ensuite, ils sont repassés à 44 kHz et moins de niveaux pour diffusion grand public. Apparemment ils se sont aussi aperçus que l'échantillonnage Nyquist-Shannon dégradait le son, comme j'espère t'avoir montré qu'il dégradait l'image... Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

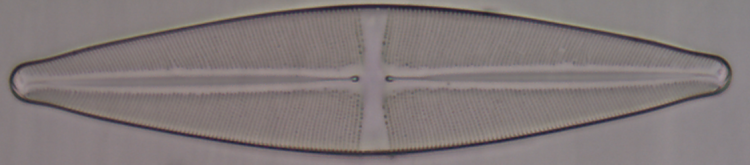

Bonjour Claude, ce n'était pas mon but. Je ne cherchais pas à obtenir la meilleure photo possible de cette diatomée mais à montrer l'influence de divers échantillonnages du CCD sur la qualité de l'image finale. Il me fallait une image de base, avec des détails de dimensions proches de la résolution de cet objectif et ne pas la changer quand je changeais la caméra, le projectif et l'échantillonnage. Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Bonjour Jean-Luc, Ce serait effectivement une très bonne idée que d'autres membres fassent le même genre d'essais avec des matériels divers car cela permet de mieux cerner la qualité d'enregistrement des CCD que nous utilisons. Les photos que j'ai prises cherchent uniquement à qualifier la qualité de restitution d'une même image par des CCD, pas à mesurer la qualité de la chaîne complète : éclairage, condenseur, objectif. Je ne suis pas sûr que la diatomée ait une couleur. Les différences de nuances sont dues à la balance des blancs que j'ai réglé en automatique pour les deux caméras et qui n'a pas donné le même résultat. Bonjour Cosinus, La résolution maximale est d'abord une question de qualité du microscope, en particulier l'objectif, dont la contribution à la FTM est primordiale, d'éclairage, de coloration de la préparation ou d'autres moyens d'augmentation du contraste. Quand tout ça est optimisé on a la "meilleure image possible, c'est à dire avec la meilleure résolution et le meilleur contraste" au foyer de l'objectif (ou de la lentille de tube si on travaille avec des objectifs "infini") : "image intermédiaire". C'est ta question qui est à l'origine de cette discussion : comment visualiser au mieux cette image sur un écran. L'écran a un peu disparu de la discussion qui s'est concentrée sur la plus ou moins bonne qualité des CCD pour enregistrer cette image intermédiaire sans la dégrader. J'espère avoir montré que le critère de Shannon-Nyquist développé à l'origine pour des problèmes d'échantillonnage de signaux temporels ne s'applique pas tel quel en imagerie. Ce théorème dit que l'information spectrale est présente. Il ne dit pas qu'il n'y a pas de dégradation du signal. D'ailleurs les enregistrements audio professionnels sont faits à 192 kHz et pas à 30 kHz qui suffiraient si on appliquait strictement ce critère aux sons audibles. Donc 6 fois mieux que Nyquist. Est-ce-qu'on n'a pas vu quelque chose d'approchant dans la discussion ci-dessus ? Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

C'est dur à suivre car Tryphon fait des rajouts dans ses messages... " Citation Rien de curieux là dedans, l'explication est donnée ci-dessus." Pas du tout : la caméra à 16 Mpixels, sous-utilisée à 4 Mpixels devrait donner une image voisine de la caméra 3 Mpixels or l'image est bien plus mauvaise. "Bon,ce n'est pas le nombre d'opinions dans un sens ou un autre qui fait la vérité, je préfère me faire une idée moi-même." Je pense que les images que j'ai envoyées sont assez parlantes. "Oui, mais, il ne faut pas en tirer des conclusions erronées. Dans le deuxième cas, il y a plus de pixels dans l'image, il est tout à fait logique que l' images vue à la même échelle, paraisse moins "pixellisée" . Le problème est de savoir si ces pixels plus petits correspondent à une réalité. Pour celui qui regarde l'image, les pixels existent bien , même si on multiplie leur nombre par 10, 100, 1000 ! Et si on regarde toujours l'image finale à la même échelle, l'image sera pratiquement toujours la même." Pas du tout ! tu trouves que les images que j'ai mises, qui sont à la même échelle, sont les mêmes !!! "Mais il n'y aucun détail supplémentaire !" C'est une idée fixe ! je n'ai jamais dit qu'on verrait plus de détails. L'objectif donne une image des trous de la frustule. Le CCD se doit de représenter ces trous le mieux possible en ne dégradant pas l'image donnée par l'objectif. "Deux points non résolus , ne le deviendront pas pour autant en diminuant la taille des photo-sites." Bien sûr ! ai-je jamais dit ça ? Encore une fois la microscopie consiste à faire une image exacte d'un végétal, d'un animal, d'un minéral,...pas de séparer deux points. C'est un travail d'astronome. -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

D'accord, je ne sais juste pas ce que fait l'électronique de la caméra quand on demande une image avec moins de pixels. Rien de très bon à voir les résultats... Et merci pour la remise en forme du message. Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

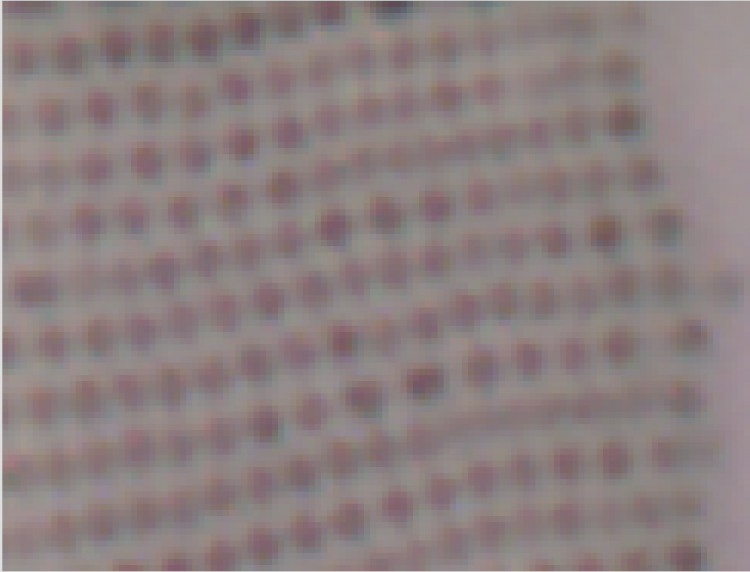

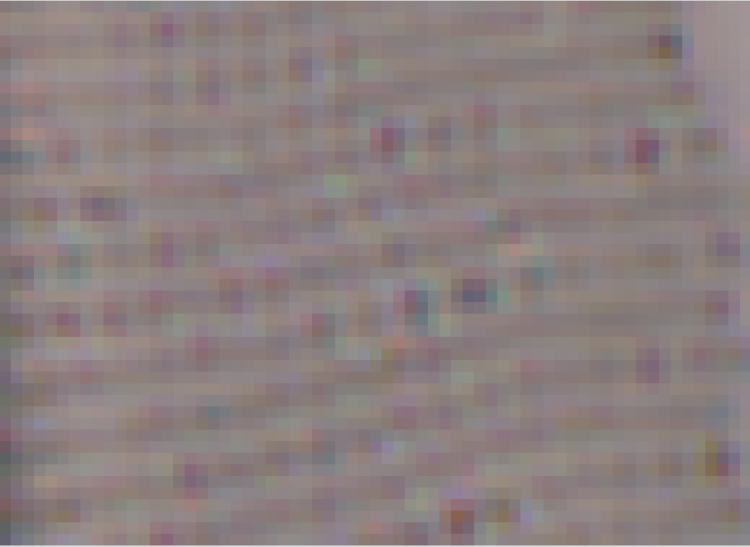

Conditions et résultats des essais Microscope Orthoplan Objectif Nikon Fluor 40x, ON 0,85 160 /0,11-0,23 mm, pas utilisé à pleine ouverture (2/3 environ) Condenseur achromatique ON 0,9 Utilisation ou non d’un projectif 0,5x sans marque. Le réglage du condenseur n’est jamais retouché. L’intensité peut varier ainsi que la mise au point car je ne suis pas parfocal entre caméras. Caméra Motic 3 Mpixels Capteur de 6,55 x 4,92 mm. Pixel de 3,2 x 3,2 µm Caméra Tucsen Digiretina 16 de 16 Mpixels Capteur de 6,12 x 4,6 mm. Pixel de 1,335 x 1,335 µm (donnée constructeur, je ne suis pas sur que le nanomètre soit significatif !) Les deux caméras peuvent être utilisées à pleine résolution ou avec 4 fois moins de pixels, mais dans ce dernier cas je n’ai aucune idée de ce que fait l’électronique du capteur pour diviser par 4 (coefficient deux sur chaque axe) le nombre de pixels : ne pas prendre en compte un pixel sur deux et ignorer une ligne sur deux ou moyenner 4 pixels voisins. J’ai tendance à penser que c’est l’ignorance des pixels qui est utilisée, car ça gagne du temps par rapport à la collecte de tous les pixels et leur moyennage, mais il y a des processeurs rapides dans la caméra et aucune information dans la squelettique documentation... Les images ont été enregistrées en .png pour ne pas faire de compression/décompression. Je n’ai fait aucun traitement d’image, sauf sélectionner un morceau d’image à peu près au même endroit et à peu près de la même taille sur toutes les prises de vue. J’ai ensuite zoomé à l’écran ces échantillons à la même dimension où on peut voir les pixels élémentaires de la prise de vue, plus ou moins gros évidemment. Je n’ai pas cherché à faire de belles images, on pourrait les améliorer avec des logiciels appropriés… Diatomée utilisée : Stauroneis phoenicenteron Un calcul très approximatif de l’objectif (supposé limité par la diffraction) donne une résolution limite de 1,22 x 0,55 : (0,7 x 2) = 0,48 µm (soit 19 µm dans le plan image). Le critère de Nyquist souvent invoqué (à tort) correspondrait à des pixels de 10 µm. Les trous de la frustule sont espacés d’environ 0,65 µm. On est donc proche de la limite. Au grossissement de 40, dans le plan image, qui est le plan du CCD, l’espacement entre trous est de 0,65 x 40 = 26 µm. Caméra 3 Mpixels : On réussit à peu près à compter 8 pixels entre centre de trous, ce qui fait 24,8 µm, cohérent avec les 26 évoqués plus haut. Les trous sont bien visibles, quoique échantillonnés (« pixellisés »). La même caméra sous-échantillonnée par le capteur avec 0,75 Mpixels (correspondant à des pixels de 6,4 µm): La même caméra avec le projectif 0,5 x, ce qui revient à des pixels de 6,4 µm : Ce devrait être la même chose que la précédente ; ça y ressemble un peu avec des différences dues à la méthode de sous-échantillonnage d’une part et aux aberrations introduites par le projectif d’autre part. Dans ces deux cas, les images ne sont pas belles, mais on perçoit que la fréquence spatiale correspondant aux trous existe La même caméra avec à la fois le projectif 0,5x et le sous-échantillonnage au niveau de la caméra, ce qui revient à un pixel équivalent à 12,8 µm : A l’œil on ne perçoit plus grand’chose des détails de l’objet ; on devine une fréquence spatiale avec des crêtes orientées haut-gauche vers bas-droite, qui correspondent à une fréquence spatiale présente dans la diatomée, de plus basse fréquence que l’espace entre trous. Caméra 16 Mpixels Pleine résolution : La pixellisation a pratiquement disparu. Image à comparer à celle de la caméra 3 M pixels. C’est le bruit qui commence à devenir perceptible (réglage de la caméra probablement pas optimisé ; je débute avec celle là et le logiciel pour Mac est faiblard). La visualisation de la forme des trous est excellente. La même caméra utilisée à résolution moitié, soit 4 Mpixels, d’où pixel théorique de 2,7 µm à comparer aux pixels de 3 µm de la première caméra : Curieusement le contraste est fort, mais la définition misérable. Je n’ai pas pu utiliser la caméra 16 Mpixels avec le projectif 0,5 car il n’y a pas de fonction zoom sur l’écran de l’ordinateur quand on est dans le logiciel de commande de la caméra qui visualise la totalité du champ de la caméra sur l’écran. On ne voit donc pas les détails fins et la mise au point est impossible ! Conclusion Une première conclusion simple : ne pas utiliser les caméras à des définitions (électroniques) inférieure à la définition nominale. C’est en tous cas vrai pour ces deux caméras. La conclusion, objet de tant de débats : un échantillonnage proche de Shannon-Nyquist est très insuffisant pour obtenir une image de bonne qualité. Il est suffisant pour capter la fréquence spatiale correspondante, que l’on retrouvera dans le plan des fréquences spatiales si on fait la transformée de Fourier de l’image, et c’est tout ce que Shannon-Nyquist ont voulu dire, mais pas du tout adapté à de l’imagerie de bonne qualité. Un échantillonnage à 3,2 microns, c’est à dire Nyquist /3 est correct, mais montre encore une dégradation. L’échantillonnage à 1,3 microns, soit Nyquist/7,5 paraît bien suffisant. On peut probablement tolérer moins, mais je n’ai que ces deux caméras ! Cette conclusion est bien connue depuis longtemps par les personnes qui s’occupent d’imagerie. Elle est ignorée ou occultée par des gens qui ont mal digéré des rudiments de traitement du signal et/ou qui ont des intérêts commerciaux contraires. Amicalement -

Test Capteur Resolution

jmaffert a répondu à un(e) sujet de Jean-Luc Bethmont (Picroformol) dans Appareils de prise de vue

Bonsoir, l'image de Jean-Luc a un champ trop grand pour qu'on puisse apprécier la résolution ultime de l'objectif. Il faut regarder un trou de la diatomée, par exemple, en coupant un échantillon sans aucun groupement électronique de pixels. Ton image a 5 Mpixels que tu ne peux pas présenter en entier sur nos moniteurs de toutes façons. La présentation de Cosinus correspond plus à ce qu'il faut faire, mais il n'y a pas de fréquences spatiales élevées dans cette photo. Il est donc difficile d'apprécier la qualité des caméras. La manip de Tryphon sur son carré est une excellente démonstration de l'empilement des FTM. La première transformation a rendu flous les bords (disparition des fréquences spatiales élevées) et baissé le contraste. La deuxième transformation a fait disparaitre définitivement le contraste... Amicalement